Bayesian Theorem (2021/3/16)

현대의 AI 및 머신러닝에 가장 핵심개념인 베이지안 공식을 다루었다. 그중에서도 기본적인 Bayesian Theorem에 관련하여 배웠다. 이전에 배운내용이라 새로운 것은 없었지만, 다시 한번 기초를 다듬을 수 있었던 시간이였다.

오늘은 개인적으로 정리하고 싶은 내용들만 적으려고 한다.

베이지안 통계학(Bayesian Statistics) VS 고전 통계학(Frequentist)

통계학에서는 크게 두가지의 다른 방식이 존재한다. 베이지안 통계학과 빈도주의적 통계학이다. 이번시간에는 짧게나마 그 둘의 특징과 차이점은 무엇인지 알아보려한다.

고전 통계학(Frequentist):

현재 가지고 있는 데이터로만을 활용하여 실험의 근본적인 사실을 바탕으로 예측을 하는 것이다.

특징:

- 절대로 가설의 확률을 사용하거나 제공하지 않는다.

- 관찰되거나 관찰되지 않은 모든 데이터의 Likelihood를 의존한다.

- Prior을 요구하지 않는다.

- 컴퓨터로 계산을 요구할 때 덜 무거운 경향이 있다.

베이지안 통계학(Bayesian Statistics):

Posterial ∝ Prior * Likelihood

베이지안 추론의 방법은...

1. 객관적인 추측으로 구하고자 하는 parameter의 관한 prior distribution을 잡는다. - Prior은 informative 또는 uninformative의 형태로 잡을 수 있다.

2. 데이터를 모은다.

3. 모은 데이터를 통해서 prior을 업데이트 시켜나간다.

4. Bayes' Rule을 통해서 Posterial을 얻는다.

Key Point는 계속해서 prior을 업데이트해나가며 모델의 정확성을 높이는 것!

특징:

- 가설과 데이터에 관련한 확률을 사용한다.

- Prior와 Likelihood에 의존한다

- 숙련된 'Subjective prior' 사용이 중요하다

- 컴퓨터로 계산을 요구할 때 parameter의 수가 많아서 더 무거운 경향이 있다.

가졌던 질문

문제에서 나온 정보

1) 객관식문제이며 알거나 찍어야한다.

2) 학생이 답을 알 확률은 p이고, 답을 찍어서 맞출 확률이 1/m이다.

시도 1:

객관식문제의 유형 (예를들어 4지선다형인지 5지선다형인지에 대한 정보)에 관련한 정보가 없으므로 Prior probability를 얻을 수 없다는 판단하에, 이유불충분의 원리로 맞을 확률과 틀린확률을 50:50으로 선택하였지만 Grading의 결과값과 다름.

시도 2:

"학생이 답을 안다면 무조건적으로 정답을 고른다."라는 전제하에서 풀면 문제없이 Grading의 결과값과 같음.

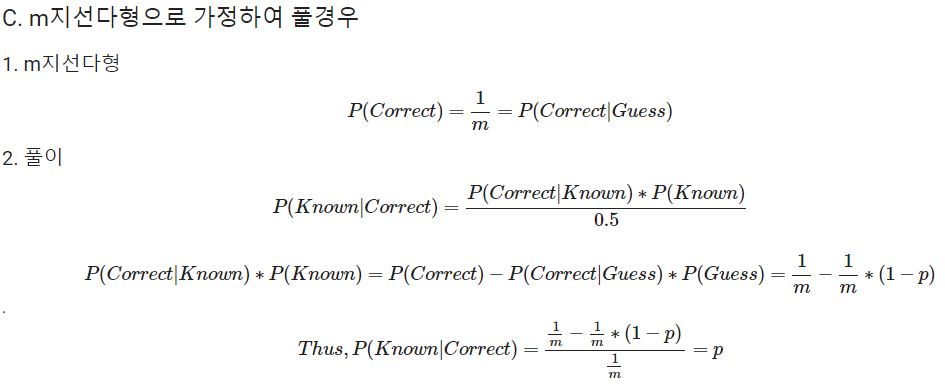

시도 3:

객관식문제의 유형이 m지선다형으로 가정하여 풀었다.

질문:

시도 1과 시도 2의 가장 큰 차이점은 주어진 정보안에서 부차적으로 전제조건("학생이 답을 안다면 무조건적으로 정답을 고른다.")을 달아야 한다는 것인데, 주어진 정보로 얻을 수 있는 정보라고 하기에는 무리가 있어보였다.

고민의 이유:

베이지안 기법을 사용할 때에는 Prior의 의존도가 상당히 많기에 Prior을 정의하는데에 있어서 굉장히 조심스럽게 접근해야한다. 이 문제와 같이 prior를 이유불충분의 원리로서 uninformative prior를 쓴 경우 (시도 1) 값이 다르게 나오게 된 듯 하다.

이전시도와는 다르게, m지선다형으로 풀었을 경우 (시도 2)에는 informative prior로서 맞출 확률을 prior로 두고 접근하였다. 하지만 prior의 관한 정보가 'Subjective'한지는 미지수이다.

반면에, 'Subjective Prior'로서 '학생이 답을 안다면 무조건적으로 정답을 고른다'라는 전제조건으로 접근을 하게 될 경우 posterial의 값이 결과값과 동일하게 나왔다.

결론적으로, 베이지안 기법은 Prior의 크게 영향을 받는 것을 이번 고민을 통해서 더 깨닫게 되었다. 두통을 얻었지만 꾀나 성공적인 고민이여서 뿌듯!

나중에 공부해보고 싶은 내용: 넷플릭스 추천알고리즘

- Naive Bayes

- Matrix Factorization

- GBDT

- RBM

- TF-IDF

Reference:

cxl.com/blog/bayesian-frequentist-ab-testing/

Bayesian vs Frequentist A/B Testing (and Does it Even Matter?)

It's a debate that dates back a few centuries, though modernized for the world of optimization: Bayesian vs Frequentist a/b testing. Does it matter?

cxl.com

'[코드스테이츠] AI부트캠프2기 > Section 1' 카테고리의 다른 글

| [AI부트캠프 2기] - 11일차 (feat. 코드스테이츠) (0) | 2021.03.18 |

|---|---|

| [AI부트캠프 2기] - 10일차 (feat. 코드스테이츠) (0) | 2021.03.17 |

| [AI부트캠프 2기] - 8일차 (feat. 코드스테이츠) (0) | 2021.03.15 |

| [AI부트캠프 2기] - 6~7일차 (feat. 코드스테이츠) (0) | 2021.03.12 |

| [AI부트캠프 2기] - 5일차 (feat. 코드스테이츠) (0) | 2021.03.11 |

댓글